Lulus 2020, Diindeks Meski Diblokir Robots.txt Google Search Console

BloggingPenjelasan Mengenai Robots.txt

Saya menggunakan hosting Blogger, Sebenarnya di dalam konfignya sudah memiliki file robots.txt default namun inilah yang menyebabkan peringatan itu muncul. Berikut ini adalah file robots.txt dari Blogger:

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.teknisiserbabisa.com/sitemap.xmlPada file robots.txt default Blogger terdapat syntax:

Disallow: /searchYang artinya tidak memperbolahkan mesin pencari merayapi URL /search setelah alamat URL blog.

Sebagai contoh:

https://teknisiserbabisa.com/search?q=un

Dalam url di atas digunakan dalam pencarian artikel dalam blog yang terdapat kata "UN". Selain digunakan dalam metode "search" fungsi dari /search untuk mencari label serta menampilkan semua postingan yang terdapat dalam blog.

Kasus yang Saya Alami

Saat membuka Google Search Console mendapati notifikasi yang berisi:

- Peringatan “Diindeks, meski diblokir oleh robots.txt” muncul pada 13 Mei 2020

- Tetapi maslah dapat teratasi dan lulus pada 16 juni 2020

Cara Mengatasi Peringatan Google Search Console

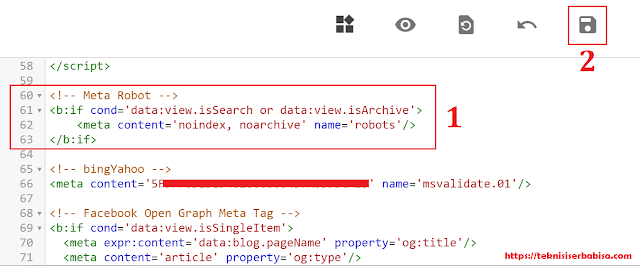

1. Tambahkan meta robot pada template blog.

- Masuk ke dashboard Blogger >> Tema >> Edit HTML

- Cari tag <head> Lalu tambahkan kode berikut ini di bawahnya dan "Simpan"

<!-- Meta Robot -->

<b:if cond='data:view.isSearch or data:view.isArchive'>

<meta content='noindex, noarchive' name='robots'/>

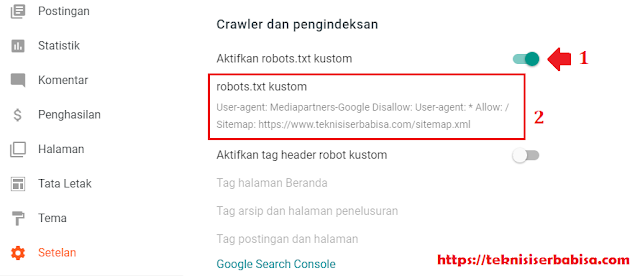

</b:if>- Kembali ke dahboard Blogger >> Setelan >> Cari Crawler dan Pengindeksan

- Lalu pilih “Aktifkan robots.txt kustom”

- Pilih “robots.txt kustom” lalu tambahkan kode di bawah ini, jika sudah jangan lupa untuk pencet “Simpan”

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Allow: /

Sitemap: https://www.teknisiserbabisa.com/sitemap.xml

Sitemap: https://www.teknisiserbabisa.com/atom.xml?redirect=false&start-index=1&max-results=500

Sitemap: https://www.teknisiserbabisa.com/feeds/posts/default

Sitemap: https://www.teknisiserbabisa.com/sitemap-pages.xmlNote:

- Ganti URL Blog dengan milik Sobat sendiri,

- Tambahkan baris kode sitemap lagi jika postingan blog sudah terlampau banyak. Melebihi 500 atau 1500

Contoh:

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Allow: /

Sitemap: https://www.teknisiserbabisa.com/sitemap.xml

Sitemap: https://www.teknisiserbabisa.com/atom.xml?redirect=false&start-index=1&max-results=500

Sitemap: https://www.teknisiserbabisa.com/atom.xml?redirect=false&start-index=501&max-results=500

Sitemap: https://www.teknisiserbabisa.com/atom.xml?redirect=false&start-index=1001&max-results=500

Sitemap: https://www.teknisiserbabisa.com/feeds/posts/default

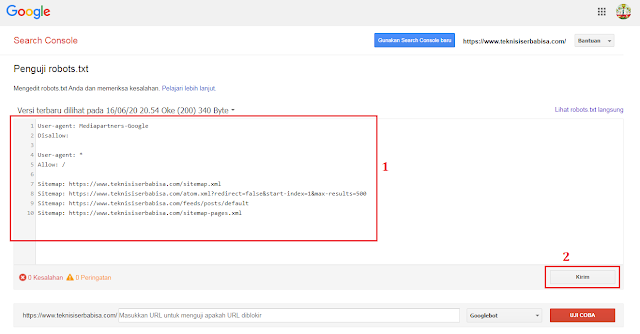

Sitemap: https://www.teknisiserbabisa.com/sitemap-pages.xmlKita cek pada file konfigurasi pada robots.txt yang berada pada Google Search Console, klik di sini. Jika sudah masuk. pilih blog yang akan dibenahi.

Kemudian masukkan lagi format file robots.txt yang baru pada kolom kotak berwarna merah, lalu pilih "Kirim"

Penutup

Begitu temen-temen cara mengatasi "Peringatan Google Search Console" semoga dapat membantu memecahkan permasalahan yang Sobat alami saat ini. Semoga berhasil

Referensi:

- sugeng.id

- arlinadzgn.com